萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

渲染一个精细到头发和皮肤褶皱的龙珠3D手办,有多复杂?

文章插图

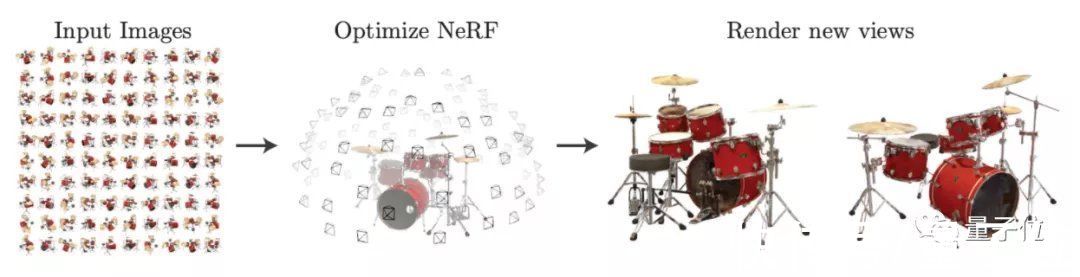

对于经典模型NeRF来说,至少需要同一个相机从特定距离拍摄的100张手办照片。

但现在,一个新AI模型只需要40张来源不限的网络图片,就能把整个手办渲染出来!

文章插图

这些照片的拍摄角度、远近和亮暗都没有要求,还原出来的图片却能做到清晰无伪影:

文章插图

甚至还能预估材质,并从任意角度重新打光:

文章插图

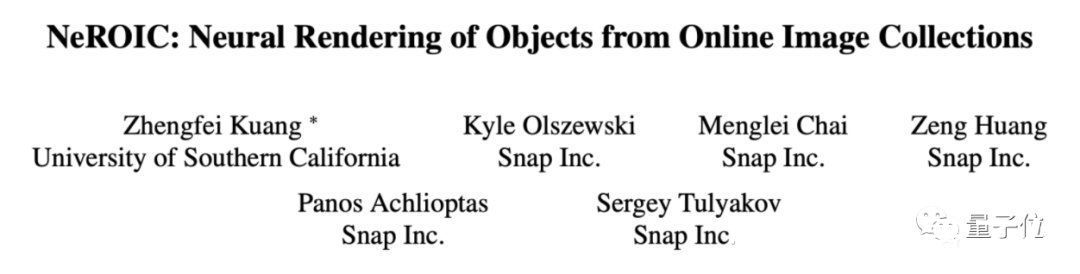

这个AI模型名叫NeROIC,是南加州大学和Snap团队玩出来的新花样。

文章插图

有网友见状狂喜:

不同角度的照片就能渲染3D模型,快进到只用照片来拍电影……

文章插图

还有网友借机炒了波NFT(手动狗头)

文章插图

所以,NeROIC究竟是如何仅凭任意2D输入,就获取到物体的3D形状和性质的呢?

基于NeRF改进,可预测材料光照介绍这个模型之前,需要先简单回顾一下NeRF。

NeRF提出了一种名叫神经辐射场(neural radiance field)的方法,利用5D向量函数来表示连续场景,其中5个参数分别用来表示空间点的坐标位置(x,y,z)和视角方向(θ,φ)。

文章插图

然而,NeRF却存在一些问题:

- 对输入图片的要求较高,必须是同一场景下拍摄的物体照片;

- 无法预测物体的材料属性,因此无法改变渲染的光照条件。

- 输入图片的场景不限,可以是物体的任意背景照片,甚至是网络图片;

- 可以预测材料属性,在渲染时可以改变物体表面光照效果(可以打光)。

文章插图

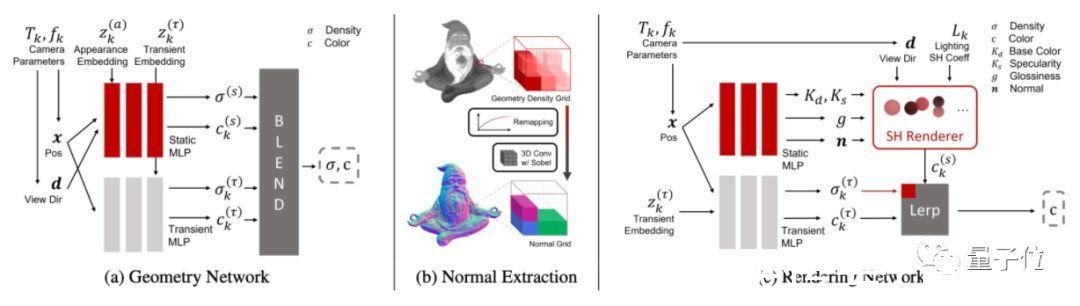

首先是深度提取网络,用于提取物体的各种参数。

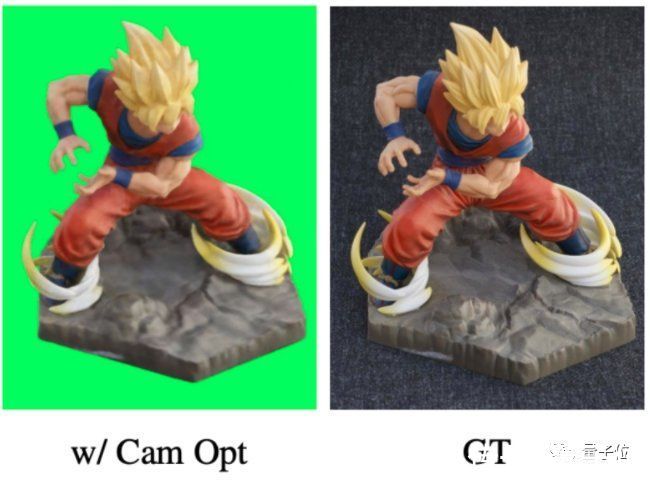

为了做到输入场景不限,需要先让AI学会从不同背景中抠图,但由于AI对相机的位置估计得不准确,抠出来的图片总是存在下面这样的伪影(图左):

文章插图

因此,深度提取网络引入了相机参数,让AI学习如何估计相机的位置,也就是估算图片中的网友是从哪个角度拍摄、距离有多远,抠出来的图片接近真实效果(GT):

文章插图

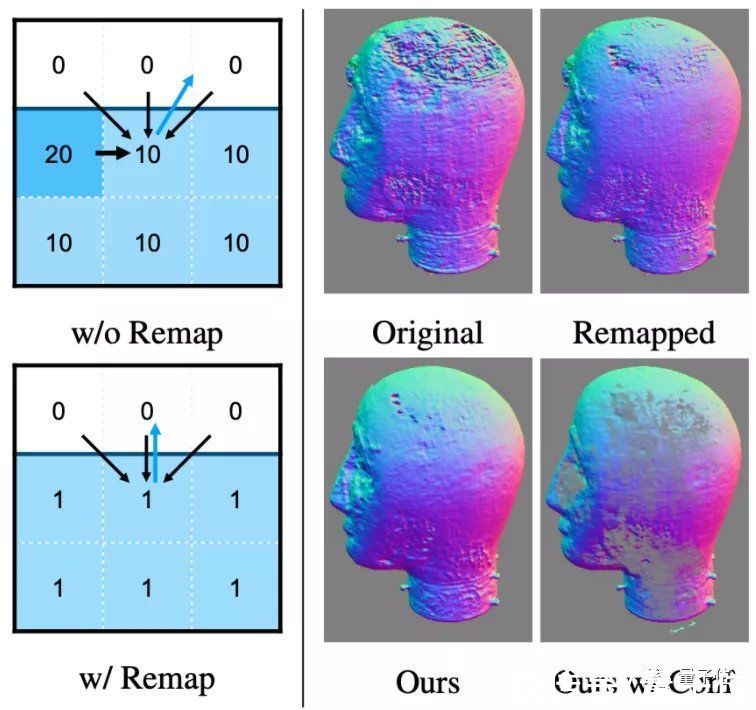

同时,设计了一种估计物体表面法线的新算法,在保留关键细节的同时,也消除了几何噪声的影响(法线即模型表面的纹路,随光线条件变化发生变化,从而影响光照渲染效果):

文章插图

最后是渲染网络,用提取的参数来渲染出3D物体的效果。

具体来说,论文提出了一种将颜色预测、神经网络与参数模型结合的方法,用于计算颜色、预测最终法线等。

其中,NeROIC的实现框架用PyTorch搭建,训练时用了4张英伟达的Tesla V100显卡。

推荐阅读

- 酷睿处理器|「手慢无」12代酷睿i7游戏本特价6799元

- i7+rtx|惠普新款暗影精灵8/8 Plus游戏本今晚开售

- hdd|联想公布 ThinkCentre M70s Gen 3 小主机,搭载 12 代酷睿

- ens|分析师预测:苹果的AR设备将按月付费订阅

- chris|Meta 称其 VR 平台自去年 12 月以来增长了十倍

- wOPPO 推出 Find X5 平板电脑、智能手表和耳塞

- srgb|华为MateBook D 15锐龙版开启预约 别错过

- Ni索尼宣布与AR手游开发商Niantic达成合作

- oled|5K轻薄本屏幕天花板!无畏Pro14性能体验兼备,2022换新首选