色情|苹果狙击儿童色情!推出这些措施 覆盖iPhone/平板等

【手机中国新闻】8月6日,手机中国了解到,苹果宣布了一项新的措施,将开始扫描iPhone中是否存在虐待儿童的图像。

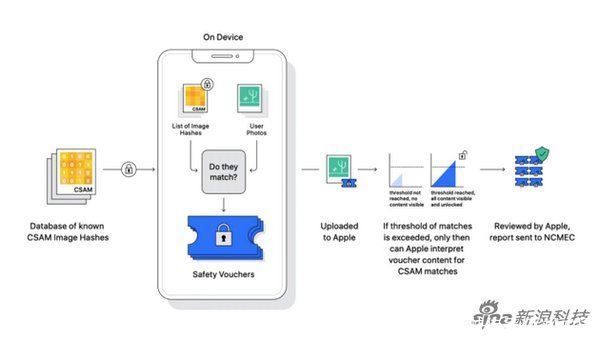

“苹果检测已知CSAM(儿童性虐待材料)的方法在设计时考虑了用户隐私,”苹果表示。“该系统不是在云端扫描图像,而是使用NCMEC(国家失踪和受虐儿童中心)和其他儿童安全组织提供的已知CSAM图像哈希数据库执行设备上匹配。苹果进一步将该数据库转换为不可读的一组安全存储在用户设备上的哈希值。”

文章插图

苹果分析图片的技术原理(图源新浪科技)

苹果在技术摘要中提供了有关CSAM检测系统的更多详细信息,并表示其系统使用阈值“设置为提供极高的准确度,并确保每年错误标记给定帐户的几率低于万亿分之一”。

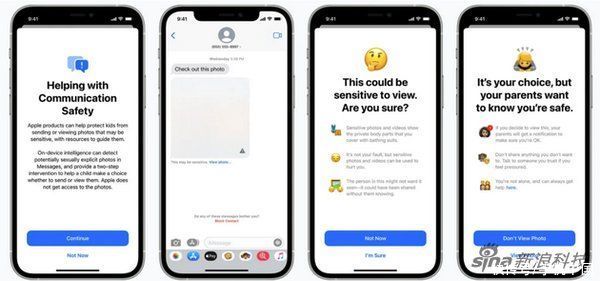

苹果表示,这些变化将在“今年晚些时候在iOS 15、iPadOS 15、watchOS 8和macOS Monterey的更新中推出”。苹果还将部署可以分析Messages应用程序中图像的软件,以开发一个新系统,该系统将“在接收或发送色情照片时警告儿童及其父母”。

文章插图

敏感图像将是模糊的,并且家庭组中父母的产品上会有通知(图源新浪科技)

“消息使用设备上的机器学习来分析图像附件并确定照片是否具有色情内容。该功能旨在使苹果无法访问消息,”苹果表示。

当Messages中的图像被标记时,“照片会变得模糊,孩子会收到警告,提供有用的资源,并保证他们不想查看这张照片也没关系。”如果孩子确实查看了被标记的照片,系统将让父母收到一条消息,并且“如果孩子试图发送色情照片,则可以使用类似的保护措施。在发送照片之前,孩子将收到警告,并且父母可以收到一条消息如果孩子选择发送它,”苹果称。

文章插图

SIri增加类似“我该怎么办”功能(图源新浪科技)

【 色情|苹果狙击儿童色情!推出这些措施 覆盖iPhone/平板等】苹果表示,它还将更新Siri和搜索,以“为父母和孩子提供更多信息,并在遇到不安全情况时提供帮助”。Siri和搜索系统将“在用户搜索与CSAM相关的查询时进行干预”,并“向用户解释对该主题感兴趣是有害和有问题的,并提供合作伙伴的资源以获取有关此问题的帮助”。

推荐阅读

- 海外市场|凭借近2亿的年销量,小米三年超越苹果的可能性有多大?

- 手机|苹果玩的是什么把戏,华为市场份额减少,反而iPhone13价格下调了

- Be苹果推出NBA限量版Beats耳机,庆祝NBA成立75周年

- iphone|苹果教你如何让 iPhone 电池保持健康

- 苹果|手机市场再次洗牌,华为跌至第六,苹果被荣耀超越,第一名很低调

- 荣耀|2021年第4季度手机销量出炉,荣耀首次位列第二,销量仅次于苹果

- 四季度|2021四季度苹果手机又赢了,荣VO米到底谁能第一个超越苹果?

- ios|苹果公司停止签署iOS 15.3 更新到15.3.1后无法降级

- ip5分钟卖出20万台!小米新品备受欢迎,这次苹果有压力了

- 魅族|库克被起诉?原因是苹果销量下滑,网友表示国产要崛起了