hud|支持动态变焦,剑桥大学基于LiDAR的全息HUD方案解析

近年来,车载AR HUD的趋势凸显,大众、奥迪等汽车厂商纷纷采用相关的导航方案,该技术的卖点是在司机眼前的大视野内显示实时路况信息,不干扰司机的视觉,同时提升汽车驾驶的安全性。

文章插图

尤其是在今年初的CES上,松下汽车展示了一款4K分辨率,且支持彩色显示、眼球追踪、远近变焦的AR HUD系统。据悉,该系统视场角高达180°,比市面上同类产品视场角更大,显示范围也更大,可在近景平面显示速度和油量,在远景平面显示自然叠加在道路环境上的3D AR导航信息。此外,通过集成的眼球追踪模块Panasonic HUD可根据司机视线去调整AR投影位置,目的是让司机专心开车的同时也能看到完整的导航信息。

实际上,与许多AR技术一样,为了保证舒适的视觉观感,避免人眼和显示屏焦距不匹配、眩晕等问题,AR HUD也需要动态可变焦功能。那么,除了通过眼球追踪技术来调节焦距外,实际上利用全息显示或视网膜投影技术也可以实现动态变焦。

比如,为了进一步提升AR HUD的体验感,由剑桥大学、牛津大学、伦敦大学学院的科研人员组成的团队研发了一种,基于LiDAR和全息技术的AR HUD方案。据悉,该方案并未采用向前挡风玻璃投影的形式,而是将AR图像直接投影到人眼中,好处是视场角更大,支持动态变焦,不过需要对人眼的位置进行校正。

利用LiDAR实时扫描环境

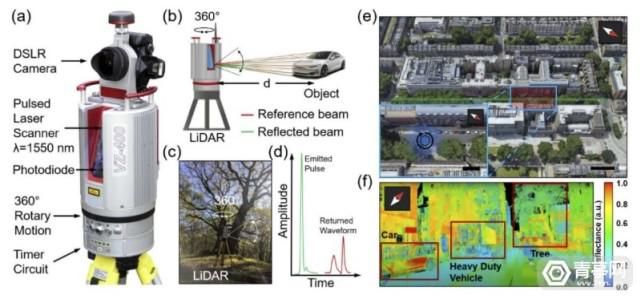

据了解,该方案利用LiDAR远程遥感技术来进行测距、识别周围的障碍物。在实际测试中,科研人员利用LiDAR和地面激光扫描的方式,收集了伦敦大学学院的一条繁忙的街道的环境数据,与点云数据结合后,重建了街道的3D模型。

文章插图

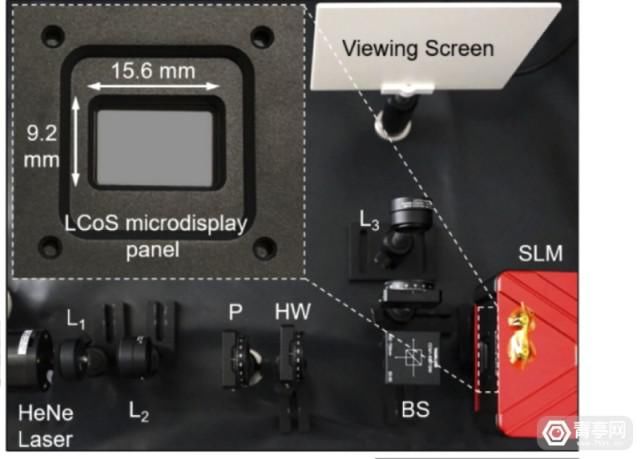

具体来讲,LiDAR数据是通过3D地面激光扫描仪来收集,然后通过计算机来转化成CGH(计算机生成的全息图)图像。接下来,该方案的显示单元由氦氖激光、超高清的空间光调制器、分辨率3840x2160的LCoS微显示屏组成,可以模拟在不同距离的空间中显示3D AR全息的效果。

LiDAR技术在3D空间建模、动态物体识别、地图测绘场景的准确性足够高,速度足够快。与传统HUD方案相比,全息HUD所需的光力学元件更少,外观设计更紧凑、更省电、可变焦距更多。

文章插图

除此之外,其硬件方案包括:氦氖激光、非球面透镜、平凸镜、消色差双合透镜、线偏振片、聚合物材质的零级半波片、非聚合物材质的分束器、光功率计接口、超高清SLM(工作波长在400到850纳米之间、刷新率达30Hz)。此外,还包括索尼α7 II E-mount全画幅数码相机、28-70mm焦距的镜头。

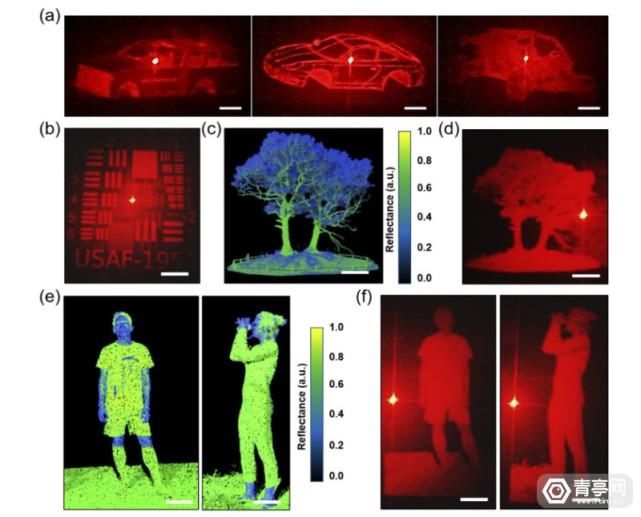

科研人员Phil Wilkes表示:我们将场景扫描数据拼接在一起,重建了整个3D环境,其中包含树、轿车、卡车、人、路标等信息。接着,科研人员利用算法提取出场景中的目标物体,并将这些目标转化为衍射图案,也就是全息投影图像。

利用全息技术实现动态变焦

科研人员表示:AR HUD可以突出被大树、卡车等物体挡住的障碍物或路牌,预先告知司机前方路况。此外,将AR投影到人眼中,意味着司机无需时刻看路,而且可以显示更加3D立体的图像。

文章插图

为了显示清晰的3D全息图像,该方案的光学元件会通过算法来投影多层不同尺寸的全息影像,这些全息影像叠加在真实环境中的特定位置,比如树后面的路牌等等,以起到提醒强调的作用。

而为了计算LiDAR数据和3D全息模型,科研人员采用了4种不同的算法,其中两种基于路线识别,另外两个利用逐点的几何特征来进行分类和标注。其中,LiDAR扫描所采用的环境分离算法在识别物体的准确率可达90%,路线识别的准确率大于80%。

推荐阅读

- 999卢比|一加Nord 2 5G手机海外发布 搭载天玑900支持65W快充

- 投资|一村资本首支QFLP基金项目完成签约,规模30亿人民币 | 投资动态

- 2022闲鱼为什么不支持信用卡付款 闲鱼可以用信用卡吗

- 5G|“不支持5G,还不降价”,面对质疑任正非强势回应

- z40|努比亚 Z40 Pro 通过 3C 认证:支持无线磁吸充电,不附赠充电器

- 微软Win11|微软Win11不再支持WEP等Wi-Fi加密协议

- fps游戏|锐龙6000+RTX 3060,支持双显三模技术,天选3锐龙版明日凌晨开售

- hdmi|支持华为、苹果,手机、笔记本皆可使用,优越者九合一扩展坞评测

- redmi|库克尴尬!Redmi K50电竞版不仅支持120W充电,亮屏也很快

- 手表|支持超级SIM卡的耳机,是未来还是“石墨烯”?