黑马|iPhone 13能透视?网友:千万别拍人

【 黑马|iPhone 13能透视?网友:千万别拍人】大家好,欢迎来到黑马公社

不知道还有多少小伙伴记得,一加8 Pro上的那颗滤光镜头。

一加本以为依靠它实现的秋意滤镜是创新是好玩,但是偏偏就因为它有一定的穿透能力,让一加8 Pro陷入了透视风波。

文章插图

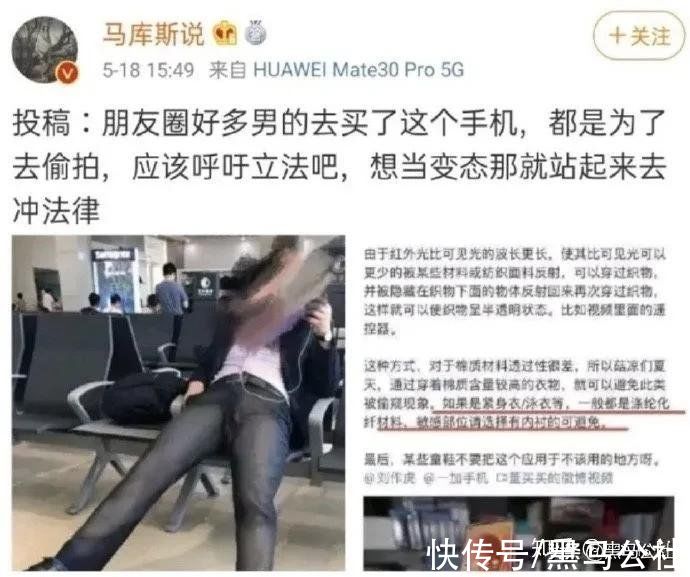

在这种情况下,没人愿意去了解事情的真相是什么,一加自己也是百口莫辩。总之,随着一阵拳打脚踢,一加最终还是通过OTA更新锁死这颗摄像头的功能。

文章插图

讲真啊,黑马也是万万没想到事情会发展成这个样子。

这或许是在意料之外,或许也在意料之中。黑马本以为从此手机厂商就不会再次触碰此类话题,没想到,却有厂商在无意之中,再次让手机拥有了“透视”功能。

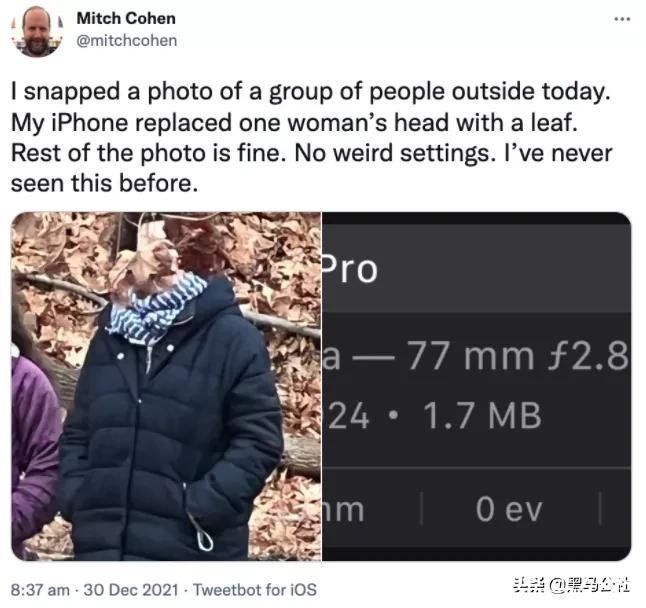

近日,就有外网小伙伴发现,用最新的iPhone 13 Pro人像模式拍照,拍出来的人居然没有头了!

喏,这个“无头骑士”就长这样。

文章插图

纳尼!

难不成iPhone拍照的真实程度,已经上升到哲学的角度了吗?或者说,它拍出了我们看不见的世界?

打住,我们要相信科学!

通过这张照片我们可以看见,人物头部位置的树叶,并非是凭空生成,它确实就是来自人物后面的背景。

所以,这到底是怎么回事呢?难不成,iPhone真的有“透视”功能?

文章插图

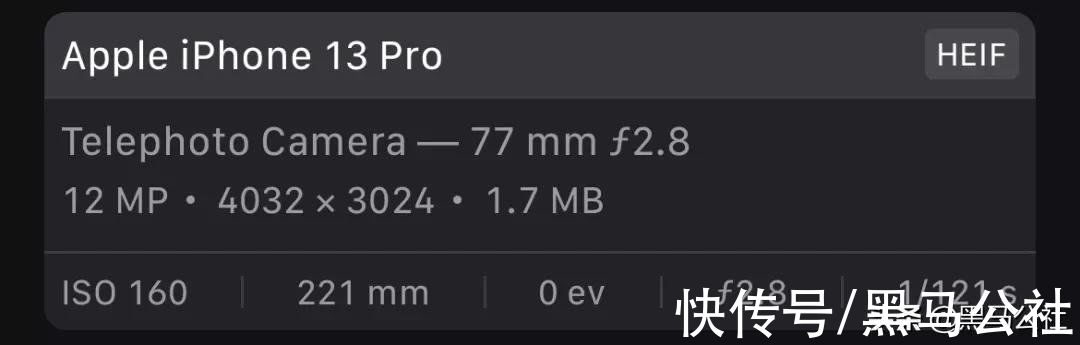

莫非是网友的相机bug造成图像缺失?

根据网友提供的照片参数可以看出,这张照片的拍摄参数非常的正常。感光度正常、光圈正常、曝光时间也是正常的。

那么,问题到底出在哪呢?

文章插图

这时候,就有网友怀疑是不是人像模式的算法问题了。

众所周知,苹果为了更好的拍照效果,推出了一个技术:Deep Fusion,简称深度融合。

它的运行原理也很简单,在拍照的时候一次性拍摄多张照片,最后通过AI算法将这些照片合成为一张。听起来像是HDR,但实际上比HDR更好。

根据苹果技术部负责人的解释是:

当你按下快门时、相机先用较高快门速度捕捉4张短时曝光的照片(把像素冻结下来避免后续使用时产生模糊的影像)。之后再拍摄4张标准曝光时长的照片。而在快门被按下的瞬间,系统还会拍摄一张长时间曝光的照片(获得更多暗部细节)。

接下来,手机先对画面元素生成一系列权重评估,譬如天空、墙壁和地板等纹理不多的素材分得较低权重,对皮肤、衣服、织品等则给予较高权重,高权重元素会从某一张该元素细节最丰富的短时曝光照片中获得细节、从合成长时间照片里获取色调、颜色和亮度,并用最高精度的高画质算法进行融合,而低权重的元素区域估计直接就拿合并长时间图片像素来做或使用低精度的快速算法进行融合(节省资源和时间)。

文章插图

黑马简单总结就是,手机拍摄多张照片,然后系统根据照片内容划分权重,最后将这些照片合成为一张照片。

有网友就在想了,会不会是拍摄过程中人物突然出现变动导致AI算法将其标记为低权重像素,然后低权重像素被抛离了呢?

目前为止,网友们最认同的就是这种说法,毕竟iPhone总不可能真的透视吧!

不过在黑马看来,这个解释其实说不太通。

推荐阅读

- oled|5K轻薄本屏幕天花板!无畏Pro14性能体验兼备,2022换新首选

- 智能汽车|北京产业转型:从“去叶留心”到发展“高”“精”“尖”

- 掏心窝|放弃iPhone13,入手华为P50 Pocket后的60天,说几点掏心窝的话

- 海外市场|凭借近2亿的年销量,小米三年超越苹果的可能性有多大?

- 手机|苹果玩的是什么把戏,华为市场份额减少,反而iPhone13价格下调了

- iphone|苹果教你如何让 iPhone 电池保持健康

- 大空间|不出冬奥村体验“上天入海”!这些智能设备令运动员着迷

- boost|性能太激进!一加10 Pro发布,不俗产品力拉开竞品差距

- indiRedmi Note 11 Pro+ 5G,Note 11 Pro India 可能在 3 月推出

- 电竞版|敢于跟iPhone叫板!Redmi K50电竞版的底气究竟在哪里?