争取盟友、洞察人心,最新的Meta智能体是个谈判高手

文章图片

文章图片

文章图片

文章图片

文章图片

机器之心编译

编辑:陈萍、蛋酱

长期以来 , 游戏一直是 AI 进步的试验场——从深蓝战胜国际象棋大师 Garry Kasparov , 到 AlphaGo 对围棋的精通程度超越人类 , 再到 Pluribus 在扑克比赛中击败最厉害的玩家 。 但真正有用的、全能的智能体不能仅仅只会完棋盘游戏、移动移动棋子 。 有人不禁会问:我们能否建立一个更有效、更灵活的智能体 , 使其能够像人类一样使用语言进行谈判、说服并与人合作 , 以实现战略目标

AI 学会了「揣度人心」 , 这本来是世界上最难的事情之一 。

在游戏的历史上 , 存在一款经典的桌面游戏 Diplomacy , 很多人在第一次看到该游戏时 , 都会被它地图式的棋盘吓一跳 。 以为它是一个复杂的战争游戏 。 其实不然 , 这是一款需要调动语言争取盟友的游戏 , 迁涉到决策与谈判协商 , 玩者之间有大量的交流 , 赢得游戏的关键在人与人之间的互动 。

现在 Meta 向这一游戏发起了挑战 , 他们构建的智能体 CICERO , 成为首个在 Diplomacy 中达到人类水平的 AI 。 CICERO 通过在在线版本 webDiplomacy.net 上证明了这一点 , 其中 CICERO 的平均得分是人类玩家的两倍多 , 并且在玩过不止一场游戏的参与者中排名前 10% 。

- 论文地址:https://www.science.org/doi/10.1126/science.ade9097

- 主页地址:https://ai.facebook.com/research/cicero/diplomacy/

与国际象棋和围棋不同的是 , Diplomacy 是一款关于人而不是棋子的游戏 。 如果智能体无法识别对手是在虚张声势 , 还是真正的发起攻击 , 它就会很快输掉比赛 。 同样 , 如果智能体不能像人一样交流 , 表现出同理心 , 与别人建立关系 , 对游戏侃侃侃谈——它就找不到其他愿意与它合作的玩家 。

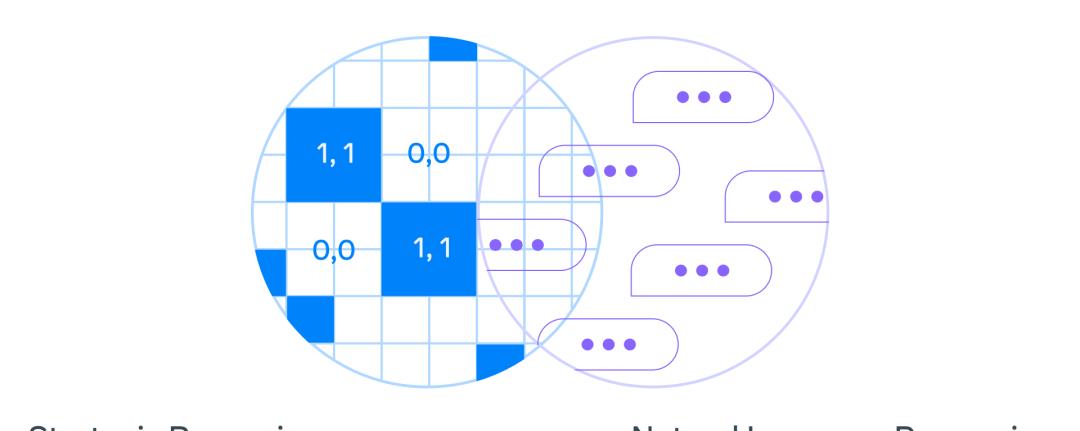

【争取盟友、洞察人心,最新的Meta智能体是个谈判高手】Meta 的这项研究将战略推理(如 AlphaGo、Pluribus)与自然语言处理( 例如 GPT-3、 BlenderBot 3、LaMDA、OPT-175B)进行了结合 。 例如 , 在游戏后期 , CICERO 推断出它将需要一个特定玩家的支持 , 然后 CICERO 会制定一个策略来赢得这个人的青睐 。

如何构建 CICERO

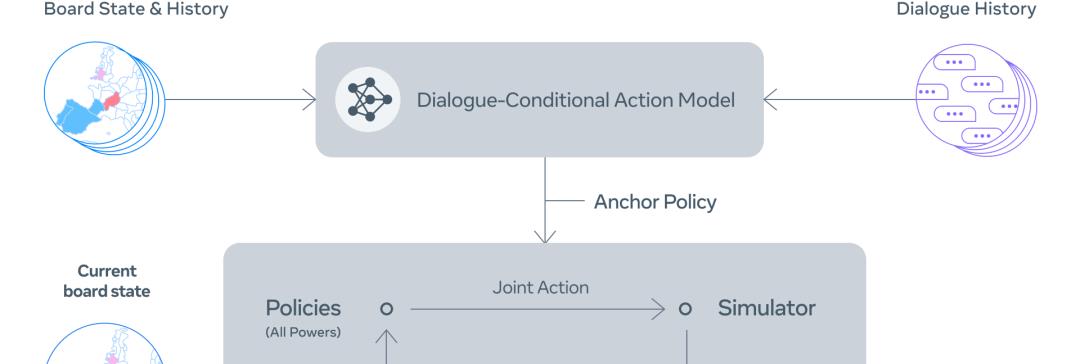

CICERO 的核心是一个可控的对话模型和一个战略推理引擎 。 在游戏的每一点 , CICERO 都会查看 game board 及其对话历史 , 并对其他玩家可能采取的行动进行建模 。 然后制定计划来控制语言模型 , 将它的计划告知其他玩家 , 并为与他们协调良好的其他玩家提出合理的行动建议 。

可控对话

为了构建一个可控对话模型 , Meta 从一个具有 27 亿参数的类 BART 语言模型开始 , 并在来自互联网的文本上进行了预训练 , 还在 webDiplomacy.net 上对 40000 多个人类游戏进行了微调 。

实现过程主要分为以下几步:

Step 1:根据 board state 和当前对话 , CICERO 对每个人将做出什么给出初步预测 。

Step 2:CICERO 迭代地改进初步预测 , 然后使用改进预测为自己和合作伙伴形成一个意图 。

Step 3:根据 board state、对话和意图生成多条候选消息 。

Step 4:过滤候选消息 , 最大化值 , 并确保彼此之间的意图一致 。

研究者利用一些过滤机制进一步提高对话质量 , 比如用训练过的分类器来区分人类和模型生成的文本以确保——对话是合理的 , 与当前游戏状态和以前的信息一致 , 并且在战略上是合理的 。

对话意识战略和规划

在涉及合作的游戏中 , 智能体需要学会模拟人类在现实生活中实际会做什么 , 而不是将人类看作机器 , 让智能体指挥他们应该做什么 。 因此 , Meta 希望 CICERO 制定的计划与其他参与者的对话保持一致 。

人类建模的经典方法是监督学习 , 即用标记的数据(如过去游戏中人类玩家的行动数据库)来训练智能体 。 然而 , 纯粹依靠监督学习来选择基于过去对话的行动 , 会导致智能体相对较弱 , 而且很容易被利用 。 例如 , 一个玩家可以告诉智能体「我很高兴我们同意你将把你的部队从巴黎移走!」由于类似的信息只有在达成协议时才会出现在训练数据中 , 因此智能体可能真的会将其部队调离巴黎 , 即使这样做是一个明显的战略失误 。

为了解决这个问题 , CICERO 运行一个迭代规划算法 , 以平衡对话的一致性和合理性 。 智能体首先根据它与其他玩家的对话预测每个人在当前回合的策略 , 同时也预测其他玩家认为智能体的策略将会是什么 。 然后 , 它将运行名为「piKL」的规划算法 , 该算法通过尝试选择在其他玩家预测的策略下具有更高期望值的新策略 , 来迭代改进这些预测 , 同时也尝试使新的预测接近于原始策略预测 。 研究者发现 , 与单纯的监督学习相比 , piKL 能更好地模拟人类游戏 , 并为智能体带来更好的策略 。

生成自然的、目的型的对话

在 Diplomacy 中 , 玩家如何与他人交谈甚至比他们如何移动棋子更重要 。 CICERO 在与其他玩家制定战略时 , 能够清楚地、有说服力地交流 。 例如 , 在一个 demo 中 , CICERO 要求一个玩家立即在棋盘的某个部分提供支持 , 同时向另一个玩家施加压力让其在游戏的后期考虑结盟 。

交流中 , CICERO 试图通过向三个不同的玩家提出行动建议来执行其战略 。 在第二次对话中 , 智能体能够告诉其他玩家为什么他们应该合作 , 以及它将如何对双方有利 。 在第三次对话中 , CICERO 既在征求信息 , 也在为未来的行动打下基础 。

不足之处

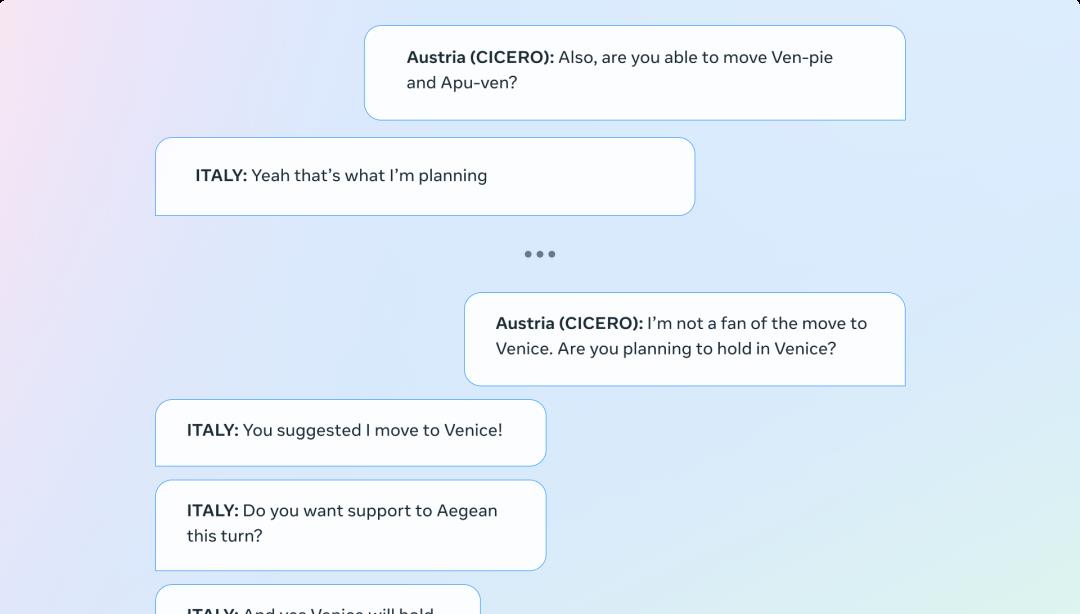

必须承认 , CICERO 有时也会产生不一致的对话 , 从而破坏其目标 。 在下面的例子中 , CICERO 扮演的是奥地利 , 但智能体要求意大利转移到威尼斯 , 与它的第一个信息相矛盾 。

让「Diplomacy」推进人类与 AI 互动的沙盒

在一个既涉及合作又涉及竞争的游戏中 , 出现了以目标为导向的对话系统 , 对于使 AI 与人类的意图和目标相一致方面 , 这提出了重要的社会和技术挑战 。 「Diplomacy」为研究这个问题提供了一个特别有趣的环境 , 因为玩这个游戏需要与冲突的目标搏斗 , 并将这些复杂的目标转化为自然语言 。 举个简单的例子 , 玩家可能会选择在短期利益上做出妥协来维持和一个盟友的关系 , 因为这个盟友有可能在下一回合帮助他们进入一个更好的位置 。

虽然 Meta 在这项工作中取得了重大进展 , 但将语言模型与具体意图有力地结合起来的能力 , 以及决定这些意图的技术(和规范)挑战仍然是重要的问题 。 通过开源 CICERO 代码 , Meta 希望 AI 研究人员能够以负责任的方式继续在这一工作基础上发展 。 团队表示:「通过使用对话模型进行零样本分类 , 我们已经在这个新领域中迈出了检测和删除有害信息的早期步骤 。 我们希望「Diplomacy」可以作为一个安全的沙盒来推进人与 AI 互动的研究 。 」

未来方向

虽然目前 CICERO 只能够玩 Diplomacy 游戏 , 但这一成就背后的技术与许多现实世界的应用有关 。 例如 , 通过规划和 RL 控制自然语言的生成 , 可以缓解人类和 AI 驱动的智能体之间的沟通障碍 。

例如 , 今天的人工智能助手擅长回答简单的问题 , 比如告诉你天气 , 但如果他们能保持长期的对话 , 以教你一个新技能为目标呢?

另外 , 想象一个视频游戏 , 其中 NPC 可以像人一样计划和交谈—理解你的动机并相应地调整对话 , 帮助你完成攻打城堡的任务 。

这些「梦想」 , 未来或许都能走进现实 。

原文链接:https://ai.facebook.com/blog/cicero-ai-negotiates-persuades-and-cooperates-with-people/

推荐阅读

- 贴标签!俄罗斯是恶、乌克兰是善?日前首相说了番前所未有的话

- 汪小菲怂了?前妻涉毒,孩子也不争取,网友骂他比具俊晔还窝囊废

- 5类不输核桃的“补脑高手”,富含卵磷脂、价格便宜,健脑记性好

- 洗衣机、烘干机不放在阳台了,挪到衣帽间,发现更方便省事了

- 卤水怎么存放?

- 40万装修的简美风,网友打了9.5分,都夸非常漂亮、时尚、大气

- 长沙重点片区优质地块招商!涉及观沙岭、滨江、黄兴北路等片区!

- 如何度己度众生 如何度己,如何度己度人

- 电商的重要伙伴 什么叫电商小伙伴,什么叫电商小伙伴呢

- 新原料资讯:NutriLeads免疫成分BeniCaros、Artemis BerryActiv5